依賴與動態( dynamic )環境的資料(隨著外部條件變化而改變的資料)重複互動

以最大化累積回報( cumulative reward )找出能夠產生最佳結果的策略

是一種嘗試錯誤( trial-and-error )的學習方法

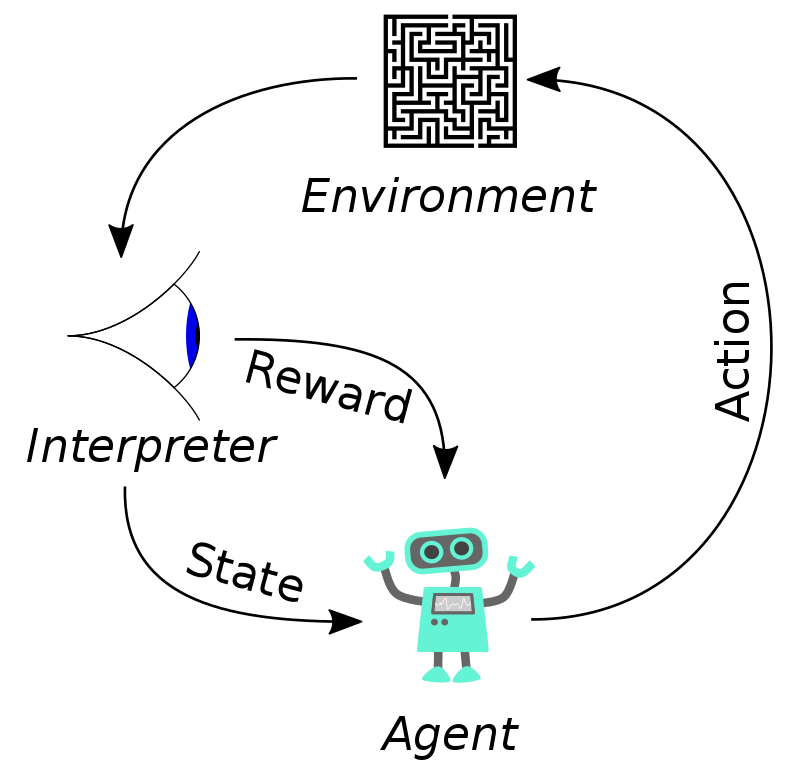

先定義一個環境,是代理進行學習和互動的地方

而環境可以是現實世界的物理系統,也可以是模擬器或虛擬環境

要確定代理和環境之間的互動方式,包括如何觀察環境的狀態、執行動作以及接收回報

獎賞是代理用來評估其行動的回饋信號,通常表示為一個數值

要定義獎賞的方式,讓代理可以根據獎賞信號來學習

而獎賞的設計通常需要多次迭代和調整

主體是代理的核心,包括策略和訓練演算法

先選擇一種策略的方法,可以使用類神經網路、查找表或其他方法

然後設計策略的結構和邏輯,讓代理可以根據環境的狀態做出動作

設定訓練的參數,像是訓練的持續時間或者停止標準

代理會根據選擇的訓練演算法來調整策略,最大化預期的長期回報

驗證訓練好的策略通常涉及模擬測試,讓策略在不同情況下表現良好

當代理的策略訓練好並驗證,可以實際應用策略部署

需要將策略轉換為程式碼或硬體形式

不用擔心主體和訓練演算法的實現,策略已經是獨立的決策系統

在訓練主體時

可能會遇到不同的問題

需要根據實際情況進行調整和改進

這時就要

如果訓練過程不能在合理的時間(或者次數)內達到收斂

就要調整訓練的持續時間、學習率、探索策略等超參數

嘗試不同的設置,來找到對於特定問題最有效的設置

不同的問題可能需要不同的演算法

如果選擇的演算法所產生的結果不好,就要嘗試其他強化學習算法

如果代理的策略不能捕捉到問題的重要特徵或結構,就要改變策略的表示方式

像是神經網絡的架構、添加或刪除層次、調整輸入特徵等

獎賞的設計可能需要多次調整

要多次重新評估獎賞訊號的種類、大小、密度等

如果代理的動作選擇或觀察訊號舞法提供足夠的資訊

需要擴展動作空間、增加感知能力或改變觀察方式

如果環境的動態性質發生變化,代理的策略可能需要調整來適應

強化學習是一個實驗性的過程

需要不斷的嘗試和調整

來找到最佳的策略

而疊代是正常的一部分

在解決複雜問題時往往是不可避免的

通過模擬環境互動,來學習最優策略的方法

使用蒐集到的完整軌跡來計算每個狀態-動作對的值

結合了蒙特卡洛和動態規劃,通過實時更新估計值來學習

使用估計值代替等待整個軌跡的實際回報,因此更適用於實時應用

基於 TD 學習,根據當下策略的某一動作後所獲得的回報以及進入下一狀態後的動作

基於 TD 學習,通常用於學習狀態-動作值函數( Q 函數)

函數估計在每個狀態下執行每個動作的值

https://www.terasoft.com.tw/support/tech_articles/reinforcement_learning_a_brief_guide.asp

https://zh.wikipedia.org/zh-tw/%E5%BC%BA%E5%8C%96%E5%AD%A6%E4%B9%A0